- Autor Stanley Ellington [email protected].

- Public 2023-12-16 00:22.

- Modificat ultima dată 2025-01-22 16:11.

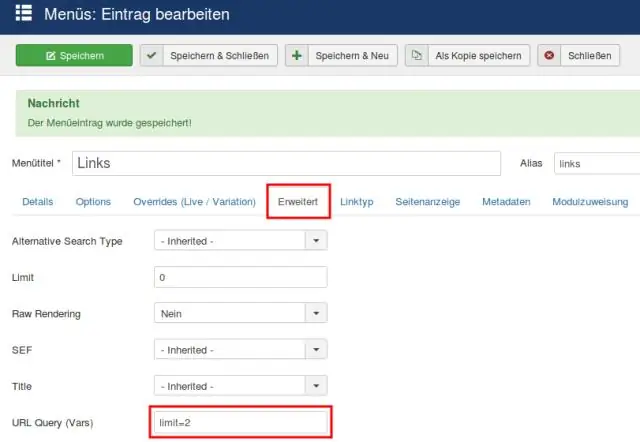

Pentru a servi un model Tensorflow , pur și simplu exportați un SavedModel din dvs Tensorflow program. SavedModel este un format de serializare ermetic, neutru din punct de vedere al limbajului, care permite sistemelor și instrumentelor de nivel superior să producă, să consume și să transforme Modele TensorFlow.

În consecință, cum rulez un model TensorFlow?

Aceștia sunt pașii pe care îi vom face:

- Faceți un model stupid ca exemplu, antrenați-l și depozitați-l.

- Preluați variabilele de care aveți nevoie din modelul stocat.

- Construiți informațiile tensorului din ei.

- Creați semnătura modelului.

- Creați și salvați un constructor de modele.

- Descărcați o imagine Docker cu TensorFlow servind deja compilată pe ea.

În plus, ce servește TensorFlow? Servire TensorFlow este un flexibil, de înaltă performanță servire sistem pentru modele de învățare automată, conceput pentru medii de producție. Servire TensorFlow oferă o integrare gata de utilizare cu TensorFlow modele, dar poate fi ușor extins la servi alte tipuri de modele și date.

În acest sens, cum funcționează serviciul TensorFlow?

Servire TensorFlow ne permite să selectăm ce versiune a unui model sau „servibil” dorim să folosim atunci când facem cereri de inferență. Fiecare versiune va fi exportată într-un subdirector diferit sub calea dată.

Ce este un server model?

Model Server pentru Apache MXNet (MMS) este o componentă open source care este concepută pentru a simplifica sarcina de implementare a învățării profunde modele pentru inferență la scară. Desfășurare modele pentru că deducerea nu este o sarcină banală.

Recomandat:

Cum inițializați o variabilă TensorFlow?

Pentru a inițializa o nouă variabilă din valoarea altei variabile, utilizați proprietatea altei variabile initialized_value (). Puteți utiliza valoarea inițializată direct ca valoare inițială pentru noua variabilă sau o puteți folosi ca orice alt tensor pentru a calcula o valoare pentru noua variabilă

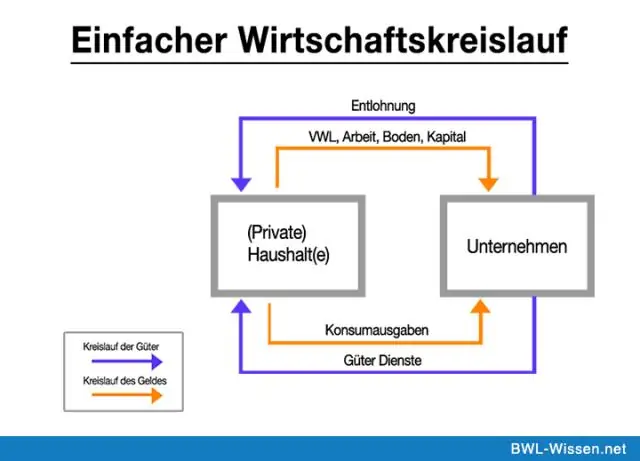

Cum funcționează un model de flux circular?

Modelul fluxului circular demonstrează modul în care banii se mișcă prin societate. Banii trec de la producători la muncitori ca salarii și revin către producători ca plată pentru produse. Pe scurt, o economie este un flux circular nesfârșit de bani

Cum salvezi un grafic TensorFlow?

Salvarea TensorFlow în/încărcarea unui grafic dintr-un fișier Salvați variabilele modelului într-un fișier punct de control (. ckpt) folosind un tf. Salvați un model într-un. pb și încărcați-l înapoi folosind tf. Încărcați într-un model de la a. Înghețați graficul pentru a salva graficul și greutățile împreună (sursă) Utilizați as_graph_def() pentru a salva modelul, iar pentru greutăți/variabile, mapați-le în constante (sursă)

Cum reutilizați variabilele în TensorFlow?

Reutilizarea cuvintelor finale înseamnă împărțirea aceleiași variabile între diferite obiecte. Dacă doriți să partajați o variabilă, a doua oară când vă referiți la aceasta, trebuie să specificați în mod explicit „reuse=True” în domeniul de aplicare al variabilei pe care doriți să o reutilizați sau. setați domeniul de aplicare a variabilei la „reuse=tf.AUTO_REUSE”

Cum afișați un grafic TensorFlow?

Pentru a vedea propriul grafic, rulați TensorBoard îndreptându-l către directorul de jurnal al jobului, faceți clic pe fila grafic din panoul de sus și selectați rularea corespunzătoare folosind meniul din colțul din stânga sus